-

Příspěvků

3268 -

Registrován

-

Aktivní

-

Vítězných dnů

64

-

Hele, za ty ceny, co máte na webu, se ještě stále dá něco takovýho tvořit? :D tyto ceny jsem měl v roce 2015 a byl jsem na to sám.. a i tak se mi to moc nevyplatilo :D

- 22 odpovědí

-

- 1

-

-

- web

- webové stránky

-

(a 3 další)

Tagged with:

-

Já budu v Praze zítra a buď středa nebo čtvrtek tak po páté čtvrté hodině někam mohu zaskočit

-

ffredyk started following Návrat ke kořenům , Pražské pawno pivko 2025 , Rock Paper Scissors and 1 other

-

S tímto s tebou souhlasím a v praxi to tak běžně je Díky tomu jak je docker (či specifická linuxová distra) lightweight, jsou využívaná v koprodukci s Windows servery já tu nehaním linux jako takový, jen haním porovnání Linux > Windows, protože oba systémy mají odlišná pozitiva a negativa a jsou navrženy na support úplně jiných druhů aplikací

-

Korporáty jedou na Active Directory, Office 365 a defakto mají celé firemní IT zázemí postavené na Microsoftu z jednoho prostého důvodu - neexistuje žádná adekvátní alternativa.. Respektive, pro každý jednotlivý komponent zcela jistě najdeš adekvátní alternativní, či open-source řešení, ale dokážeš z toho poskládat ucelený environment, který prostě funguje a nebudeš kvůli tomu muset platit IT tým specialistů za nekřesťanský prachy? Nehledě na to, že Microsoftí corporate support také funguje na trochu jiné úrovni, než jsou malí hráči zvyklí a Microsoft se nebojí ohýbat jeho produkty dle požadavků jeho největší klientely

-

To smrdí amatérským adminem, než teda problém serveru :D Nám se všechny instance aktualizují 1x měsíčně za pochodu a restart necháváme na noc o víkendu.. Avšak v nových WS 2025 nás již čeká hotpatching, který zvládne aktualizovat celý OS bez restartů Vzhledem k tomu, co out-of-the-box WS nabízí, si stále troufám tvrdit, že jeden malý restart jednou za měsíc (updaty vycházejí každou druhou středu v měsíci) je menší zlo, než nechat linuxovou černou skříňku běžet s ročním uptimem :D

-

Vzhledem k tomu, že jde o staré hry, tak nevím jak se budou v dockeru chovat :D můžeme to zkusit, ale nejradši bych setupnul už léta ověřené řešení :D

-

HW se mi válí doma, musím najít čas to postavit.. Kdo na tom chce rozjet nějaký server pod záštitou Pawno.cz (alespoň prozatím) tak ať si připraví binárky, který mi pak naposílá - já k tomu pak setupnu nějakej basic přístup kvůli opravám, úpravám a správě. Pojede to pod Windows OS - takže windowsácké binárky (na linux už jsem zanevřel dávno a v corpo světě stejně Windows Server vítězí na celé čáře)

-

Proto s tím jdu sem jestli se nás najde víc, tak se rozjede víc her sám se dokážu starat max o jednu až tři hry + technické zázemí.. Ale to by pak byl projekt o prdu, že? :D

-

Ahojda, za svou kariéru C# programátora mám na kontě nespočet projektů, experimentů a různých jiných tvoreb.. Většinu z nich jsem nikdy nevydal na světlo světa k údivu, a tento rok to chci alespoň mírně změnit. Již v roce 2022 jsem se inspiroval jakýmsi videem někde v hlubinách internetu, ve kterém v relaxačním formátu byli vyobrazeny kámen, nůžky a papír v soubojích ikonek. Hrozně mě to chytilo a mermomocí jsem potřeboval sledovat další zápasy, tak mě napadlo, že si to naprogramuju v Unity.. Z nápadu vznikl koncept, ve kterém jsem si uvědomil, že bych se těch válek chtěl účastnit a takto se nápady jen hrnuly až vznikl tento počin.. Dostal jsem do formátu, který jsem chtěl prezentovat svému okolí a překopal jsem to do verze mobilní hry, kterou jsem pak náležitě prezentoval. Mé okolí je však fantazií zaseknuté, nenadšené a já ztratil motivaci to dotáhnout do konce. Již delší dobu mě mrzí, že zrovna tuto gamesku jsem nikdy nevydal a hodlám to tento rok změnit - strávil jsem poslední dva dny překopáváním původní verze do WebGL desktopového dema, které obsahuje dva základní (avšak strategicky naprosto odlišné) módy hry. V plánu mám dodělat ještě Capture the Flag (tři vlajky na poli, kámen sbírá vlajku nůžkám a brání před papírem a vice versa) + online multiplayer. Jenž bude vlastně místnost (a pokud bude hráčů až moc, tak se přidělají místnosti) s hlasováním ohledně hranných módů na omezený počet kol Vyzkoušejte si ji hned https://gamecenter.ffredyk.cz/game.php?gameid=knp (možná ještě chytíte chybu certifikátu.. Už je vygenerován opravený, ale propagace trvá..) Běží to sice na archaickém PHPkovém mikrosystému, který jsem musel vykuchat apřekopat, ale pro tohle základní demo to zatím vystačí

-

Pro případ, že by servery (např. u Vietcongu si nedělám velké naděje) zely prázdnotou, chtěl bych to klidně udělat formou předem domluvených eventů - v kalendáři her se vybere datum, oznámí se hráčům, kteří mají zájem, že se bude hrát a v tolik se zde na pár hodin sejdeme Server pak sám vymře a po hodině nulových hráčů se sám vypne. Nedělám si iluze, zase tolik veteránů nás nebude, ale jednou za čas mít připravenej prostor i na tyto staré smažby, to přeci nemůže nikdo odmítnout :D

-

Proto jsem založil tento topic osobně mě láká primárně CoD2, Vietcong, Arma 3 a L4D2 - avšak všechny ty další hry bych klidně také rád hrál a měl svůj domácí server kam jednou za čas zavítat, pozdravit se s lidma, poklábosit, udělat soutěž apod.. Nemám v plánu se starat o vše sám, a když už tak ať je to co nejvíce autonomní. Proto hledám další nám podobné, kteří by si pod svá křídla vzali starost o servery dalších her na společném HW pod společnou záštitou

-

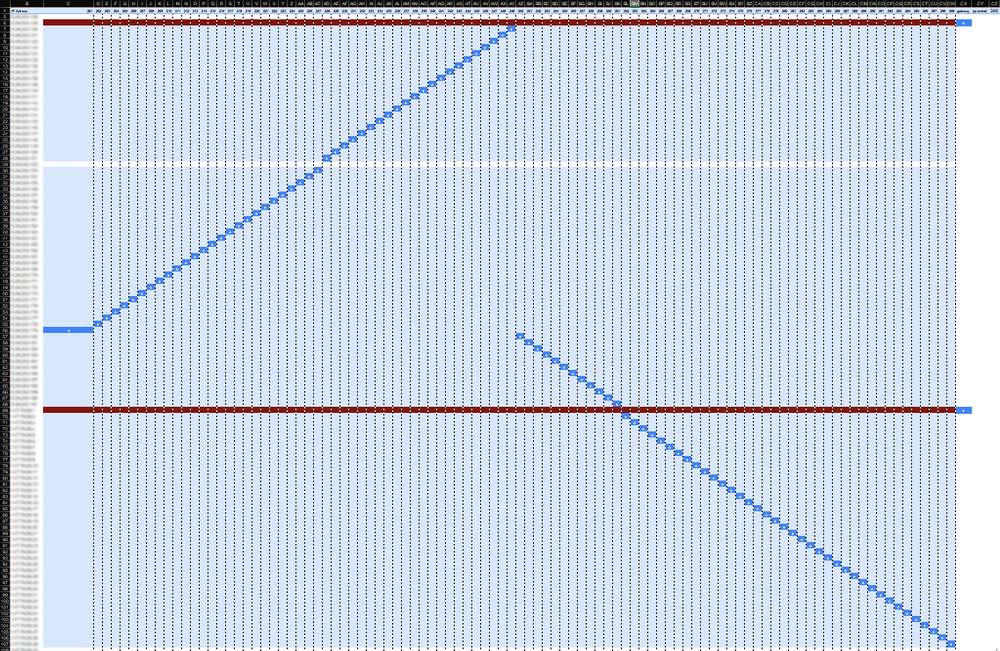

Říká se to již několik let, vlastně od uvedení prvního ChatGPT, ale široká veřejnost to naplno pocítí až tento rok. Někteří se tématu věnujete, a jiní z vás se tomu vyhýbají. Je to stále velká neznámá, ale oproti tomu co se hlásalo ještě minulý rok, máme vlastně už celkem pojem o tom, jakým směrem se s novou technologií AI řítíme. Historie o vzniku neuronových sítí, AI a samotném technickém pozadí je na netu tuna, tomu se vyhneme. Já bych se s vámi rád podíval na reálné dopady na náš nejen vývojářský život. Prozkoumáme různé úhly pohledu a nahlédneme za oponu firmám, které AI kolotoč rozjíždějí naplno. AI je již úplně všude Možná si to stále ještě neuvědomujete, ale různé formy moderní AI už dávno fungují i v těch nejnápadnějších funkcích a nejjednodušších aplikacích. Zejména produkce od velkých hráčů, je dnes už umělou inteligencí protkaná srkz naskrz. Zejména v hudebním sektoru (např. FL studio) je většina nových pluginů zcela nebo alespoň zčásti postavena na AI. Marketing je stavěn minimálně s podporou AI, editoři a redaktoři přicházejí o práci, jsou nahrazováni efektivnější a levnější AI. Profilování zákazníků, zaměstnanců, zájemců o práci, firem a všeho co profilovat lze je dnes také primární úkol pro AI. Jsme jen krůček od kompletního řízení korporátů pomocí AI (opravdu, ohrožena je i pozice CEO, AI ji zvládá lépe, rychleji a s lepšími výsledky). CGI pomalu zvoní umíráček, AI je schopné vytvářet mnohonásobně lepší a realističtější video produkci jen z výchozího materiálu a textového vstupu, za zlomek času. Samotná produkce hudby je také v loji, AI nyní generuje celé písničky na textové přání. Moderace obsahu je třeba na YouTube kompletně řízená vlastní AI. Cenzura nejen v diskuzích na internetu, ale i ve hrách a jiném obsahu je také obstarána AI. Dokonce už existuje i AI, které hlídá jiné AI. Na ukrajině již dnes testují technologii swarmu stovek dronů, které letí blízko u sebe a každý má vlastní cíl, kterého je schopný dosáhnout každý dron individuálně. A v nejbližší době nás čeká navíc technologie Mothershipů, které tyto swarmy budou automatizovaně vypouštět bez lidské kontroly na území zamořené rušičkami a zbraněmi elektronické války. AI vs Programátoři Pělo se za prvních verzí GPT, že programátorům už odzvonilo a budou první, jenž AI nahradí. Samozřejmě, profíci z oborů a AI specialisti věděli moc dobře, že to nebude tak černobílé. Takže i já, po prostudování a hlubokého ponoření do tajů a problematiky AI, jsem naprosto vychladl. Na stejné vlně jedeme i dnes, avšak má to své ale. Juniorní pozice jsou opravdu naprosto ohroženy existencí AI. Juniora dokáže AI nahradit naprosto bravůrně, a jelikož firmy lační po optimalizacích a výdělcích, junioři jsou dnes biti, naháněni vidlemi a odmítáni ze všech stran. Je to nebezpečný precends, který se již několikrát opakoval v jiných oborech (no řekněte sami, jak jednoduché je dnes sehnat spolehlivého a kvalitního truhláře za rozumnou cenu?) a v IT nyní vzniká masivní propast, která časem bude jenom expandovat. Programátoři již dnes vydělávají sumy vysoce nad celorepublikovým průměrem (kromě mě...) a absence juniorů za pár let zákonitě zvýší hlad po seniorech. Protože důchody, vyhoření, osobní cíle apod. žejo.. Faktem zůstává, že AI programátory nebyla schopna, není schopna a hned tak nebude schopna plnohodnotně nahradit. Dokáže vám napsat jakoukoliv jednoduchou appku, script, algoritmus, snippet, nebo najít a opravit problém. Co však není schopna, je navrhovat bezpečnou architekturu, optimalizovaný codebase, koherentní výstup většího rozměru a nedokáže plně zvládnout komplexní problémy, či kompatibilitu s hardwarem, které se v minulosti nikdy neřešily. To však vytváří zcela nový prostor pro využití AI jako nástroje v rukou programátora! Jako mnoho jiného, i AI je mocný nástroj, ale krutý pán Sám jsem nedokázal dlouhou dobu do svého zajetého režimu AI vměstnat rozumným způsobem. Při první virální explozi jsme všichni využívali AI na jakoukoliv blbost a defakto jsem sám sebe nahradil neschopným programátorem, po kterém jsem musel všechno opravovat, měnit a dá se říct, že jsem se dokázal hlavně inspirovat - nechal jsem se nasměrovat směry, které jsem původně nezamýšlel. Poté jsem na pár měsíců AI vysadil, dokud si nevytvořím ucelený obrázek o tom, jak a do jaké výše AI ovlivňuje mě a moje výsledky. Před vánoci jsem se k AI vrátil a dokázal ho úspěšně integrovat do mého workflow. Moje efektivita se nezdvojnásobila, neztrojnásobila ale zdesetinásobila! Jsem člověk bádavý, rád hledám nejlepší řešení a optimalizuji co se dá v rámci mých znalostí a schopností. Občas mě to dokáže natolik sežrat, vytočit nebo frustrovat, že pak scrapnu celý projekt a začínám od nuly. Je to něco, s čím bojuji snad přes desetiletí. Pravidlem se však stalo, že ve vývoji projektu vždy nastane chvíle záseku, narazím na problém, který sice mohu vyřešit nějakým vochcáním, ale když už jsem tak daleko a mám stále tak čistý a krásný kód, nedokážu prostě teď zkousnout zuby a napsat nějakou prasárnu. Začal jsem se tedy obracet na AI a v diskuzi dvou profíků jsme téma vždy rozebrali, našli možnosti, vyměnili si kritiku či dohledali vzájemně možné vektory selhání a světe div se! Problém, který bych normálně řešil celý týden, nyní řeším v rámci desítek minut. Jako příklad mohu uvést jeden z mých posledních lehčích zášprků, který mě začal deptat.. V rámci jednoho projektu vyvíjím aktualizaci, která má za úkol pracovat s IP adresami. Projekt je již zajetý a novou žádostí jest automatizace přepínání IP adres z různých rozsahů tak, aby nevznikla kolize mezi 100 stroji a každý měl přiřazenou svou IP adresu z celého poolu různých rozsahů. Není to až tak problém v kódu samotným, jako spíš že se jedná o datové peklo.. Nejhorší úkol, který můžete dát programátorovi, je práce s daty a nutnost switchovat mezi různými prostředími. K tomu všemu byla data naprosto nepoužitelná a musel jsem si extrahovat a postavit vlastní dataset. Vytáhl jsem si IP adresy ze strojů, o kterých jsem věděl, že používají jiné rozsahy a pomocí kalkulaček jsem si zjistil celou subnetu. Díky tomu jsem získal také výchozí brány sítí, které jsem ve výchozím datasetu pořádně zanesené neměl. Začal jsem si data organizovat do nového Excel sheetu s tím, že zkusím zavařit rovnou v tabulkách a nebudu psát zbytečně script, který by to rozřadil za mě - měl jsem prostě náladu a chuť na nějaké to hraní s tabulkami. Po prvotní stavbě tabulky se všemi možnými IP adresami (které jsem sprostě vycucnul z kalkulačky) a manuální asociaci všech serverů k jejich IP adresám, mě napadlo postavit matici z těchto dvou sloupců a protkat je mezi sebou. To by mi vytvořilo krásný náhled na aktuální distribuci IP adres z rozsahů a námět k dalšímu plánování rozšířené distribuce. Začal jsem stavět kostru matice a napadlo mě, že excel zcela jistě nabízí nějaké nástroje, které by mi práci ulehčili - data už jsou napsaná, proč je nevyužít a netransformovat? Nastartoval jsem chat a začal se vyptávat - AI začalo flusat nápady, návrhy i s postupy jak je použít. Matice byla hotová do pár minut. Nakonec jsem se rozhodl to ještě překopat do kontingenční tabulky, která bude stavět všechno dynamicky. Obarvil jsem datové pole navíc podmíněným formátováním, ve kterém mi zase AI pomohlo - to vymýšlení vzorečků (a to ještě v české lokalizaci) mě vůbec nebaví. Takže nyní jsem měl krásnou matici s IP adresami v řádcích a čísly serverů ve sloupcích. Na řádcích IP adres, které byly zneužity nějakým serverem, bylo nastaveno formátování, které zbarvilo celý řádek a napovědělo tak, že tato IP adresa již není volná. Stejně tak, pokud šlo o gateway, celý řádek se znepřístupnil rudou barvou. Krásná mapa volných IP adres s přehledným uceleným náhledem na řazení serverů byla na světě! Toto celé bylo možné vzniknout za zhruba 30 minut. A to jsem ani nebyl plně soustředěn. Mám z toho však strašnou radost, mozek se mi zaplavil dopaminem a už to nikdy neotevřu. Díky té mapě jsem však byl schopen smysluplně rozvrhnout zbytek volných adres a přiřadit na jeden stroj 3 adresy. To jsem později na dalším listu připravil do struktury vhodné k vložení do databáze a tak jsem i učinil. Na strojích, jenž jsou určené jen k běhu jednoho programu, bylo nutno vypnout UAC (alespoň dočasně, než se dořeší runas shell celého programu). Dělat to manuálně, tak by nám brzo hráblo - máme však již zaběhlý baťák pro manuální aktualizace (pro případ, kdy automatické aktualizace selžou - většinou se tak děje, když něco poseru), který je schopen stroj vyčistit a nainstalovat od píky i na úplně čerstvém systému jak program, tak jeho dependencies (.NET runtime apod.). Napadlo mě, když to stejně budeme vše vypouštět manuálně, zda se nedá do toho baťáku nacpat právě i vypnutí toho UAC - AI hned odpovídá ano! Lze to a i celkem jednoduše, jde jen o úpravu klíče v registru! Jen je potřeba elevated runas - není problém, s pomocí AI nám teď self-elevuje skrze powershell i tento baťák! Při testování aktualizace na produkčním stroji se člověk nikdy nevyhne nečekaným problémům (aneb Windows environment) a tentokrát šlo o chybné zadání parametrů "netsh" command lajny, kterou program zneužíval k výměně IP adres (proto ten UAC disable). Byl to jen problém v názvu adaptéru.. Na testovacím prostředí je interface nazvaný "Ethernet", na produkčních mašinách "Ethernet 2" (insert facepalm), AI bylo zneužito pro rychlé dohledání parametráže netsh commandu k zobrazení názvu adaptérů - je to stále o mnoho rychlejší než stavba přes --help nebo googlení a proklikání se na první stackoverflow topic. Však nahlédněte sami do mého myšlenkového procesu v práci s AI :D Kapitola UAC a NetSH - https://chatgpt.com/share/678983f4-e8e0-8001-aa8b-3b2c8977b0ca A kapitola Excel a jeho záludnosti - https://chatgpt.com/share/6789845d-7400-8001-b0fd-c360d1a121bc Schválně ho dávám jako druhý (i když časoprostorově vznikl jako první), protože nad některými otázkami se nejspíš pozastavíte, uculíte a půjdete dál - vězte, že nejsem Excel guru a dělám s ním dvakrát do roka, opravdu mi v závěsu jeho úchylných funkcí nedošlo, že většímenší bude i v něm o <> a čísle :D Pokračování na téma umělé inteligence zase třeba za týden rozebereme další zajímavá témata nejen o programování v režimu AI boosted - jako třeba o tom, jak AI detekovat očima člověka, jak se vypořádat s ofenzivní AI, která vás chce oškubat apod.

-

A budeš se o to starat? :D

-

Baf, Máme nový rok, všichni v něm vítejte :D Místo vymýšlení sáhodlouhých románů (vzhledem k velkému pracovnímu vytížení) o tom co se v roce 24 povedlo či nepovedlo, budu se radši věnovat činnostem aktuálním. Tesknu, ještě s dalšími pár lidmi, po herních klasikách, na kterých jsem počínal svou kariéru gamera. S mojí herní skupinou tradičně každý rok okolo vánoc probouzíme k životu hry jako CoD2, Synergy, CSka a spoustu dalších. A vzhledem k tomu, že u mě nyní vzniká takové menší serveroviště, chci využít jednu/dvě mašiny k zprovoznění herních serverů (nejen) těchto klasik. Otázka zní, je tu někdo, kdo by se toho chtěl účastnit? Ještě si pohráváme s nápady a samotným tvarem, cílem je však gameplay. Pokud by se vás tu sešlo víc, nebráním se integraci a záštitou pod Pawno.cz, případně znovuzrození portálu AltGamer (či nějaké variaci). Seznam zamýšlených her: - Call of Duty 2 (případně 4) - Garry's mod? - SA:MP - Factorio - Minecraft - FiveM (primárně asi stavba RP serveru, nejspíš i EN oriented) - CS 1.6 (či Source nebo dvojka) - Vietcong - Arma 3 (persistent bitka s pravidelnou zeusovanou mega-opkou vázanou na aktuální battlefield) - Left 4 Dead 2 Kde se dá, rozjet vlastní tvorbu (SA:MP, Arma 3), kde ne (CoD2, Minecraft) tam nacpat něco, co nás odliší alespoň mírně originálním způsobem. Financovat se to bude z dobrovolného "Premium" na měsíční bázi, který nabídne kosmetiku a prezentaci, ne však žádné herní bonusy. Kde to bude dávat smysl, lze vymyslet "Booster pack" (SA:MP = balíček prachů, pokud nebude herní mód založen na ekonomice). Nečekám však, že by šlo o nějaké zisky, spíš jen menší vykrývání ztrát

.thumb.jpeg.a9b1922f4980806b029d841cc9b322a2.jpeg)